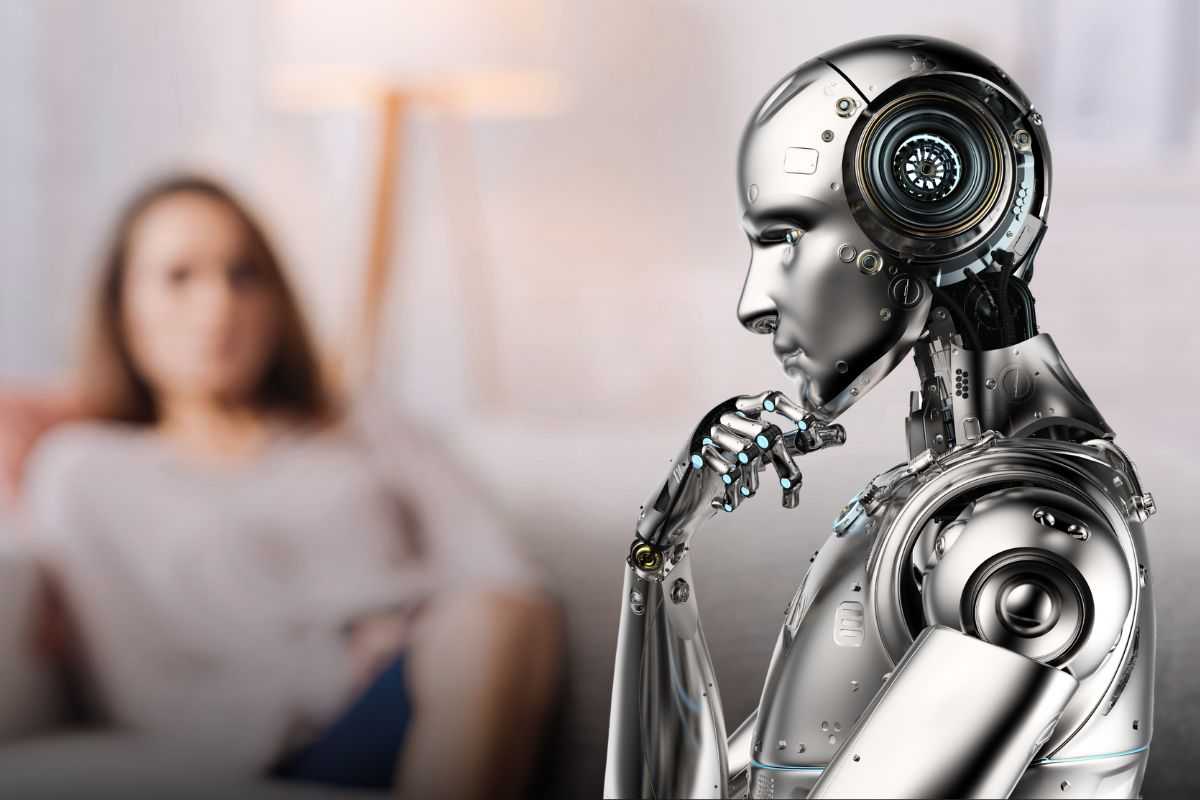

Un’intelligenza artificiale al posto dello psicologo? L’esperimento è andato virale ma per certi versi è da brividi.

Adesso che le intelligenze artificiali permeano qualsiasi settore, anche quello medico, aumentano sempre di più gli esperimenti per metterle alla prova e capire fino dove si possa spingere la loro intelligenza e capacità di ‘empatizzare’ con l’uomo.

C’è un’unica singola evidenza che gli informatici sottolineano di tenere bene a mente: le intelligenze artificiali non hanno coscienza nel senso umano del termine, perché (al momento) non possono provare emozioni, quali gioia e tristezza, e proprio per via del fatto che non hanno questa intelligenza emotiva che ci contraddistingue dall’artificiale, non riescono ad empatizzare.

Mettendo avanti questi presupposti, ci si interroga comunque in merito alla capacità delle intelligenze di dare supporto psicologico, seguendo gli schemi dell’algoritmo. A creare l’esperimento è stata un’azienda che ha promesso di dare all’utente un prodotto ‘empatico’ (attenzione però all’utilizzo del termine per i motivi che abbiamo già citato nel paragrafo precedente), in grado di comprendere i problemi e di creare una risposta razionale come risoluzione.

L’esperimento dell’AI psicologa, come funziona e quali sono i risultati e i rischi

Si chiama PI, esperimento creato da Inflection AI già nel 2022, azienda fondata da Reid Hoffman, anche il co-fondatore di LinkedIn. Pi promette una “esperienza di supporto emotivo per gli utenti umani”. È gratuito e può anche essere utilizzato per brainstorming, pianificazione, ricerca, suggerimenti e tanto altro. Le persone che l’hanno utilizzato hanno raccontato la loro esperienza: nella maggior parte dei casi si è sentito il limite della macchina, ma si ha avuto anche una buona dose di risposte incoraggianti.

Con lo psicoterapeuta non ci sono schemi e risposte settate ma la conversazione è fluida e infinita. Quello che invece fa la macchina è rispondere in modo razionale cercando la soluzione pratica più semplice al problema. Le persone hanno anche dichiarato di sentirsi spesso confortate dalle risposte dell’AI, ma che si sente comunque l’assenza umana. Quest’ultimo punto è infatti il più importante. Il grande rischio viene chiamato Effetto Eliza.

In sostanza, gli informatici sostengono che il rischio delle AI sta nel fatto che le persone potrebbero empatizzare con loro, facendoli diventare veri e propri amici, dimenticando il dettaglio fondamentale, ossia che sono appunto macchine e privi di empatia ed emozioni. Si tratta di un bias del cervello che arriva proprio perché ci si sente molto confortati a parlare con un interlocutore che ascolta, giudica poco e dispensa consigli friendly. Quindi bisogna sempre fare attenzione a non perdere il controllo delle conversazioni con le AI.